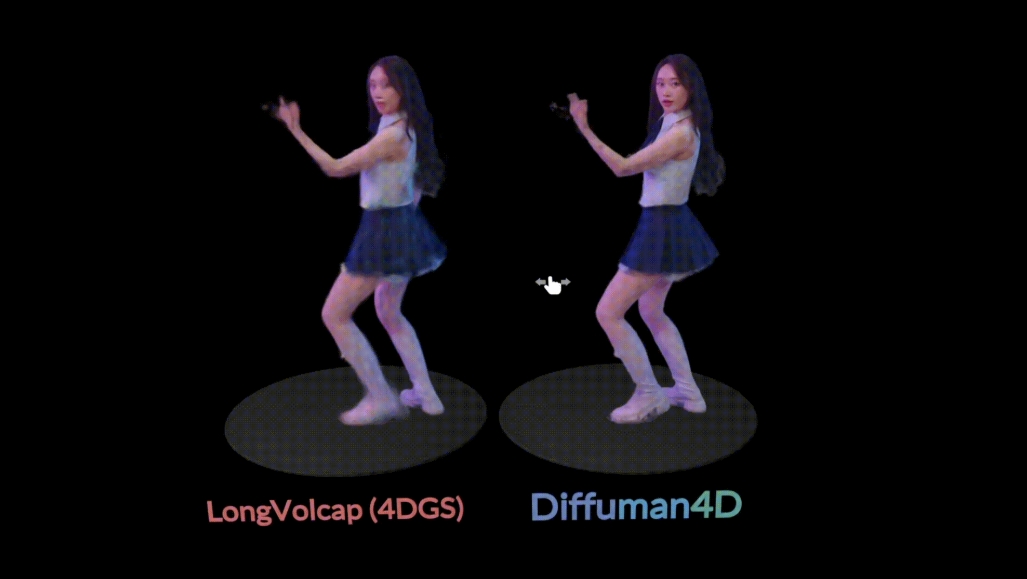

Diffuman4D

综合介绍

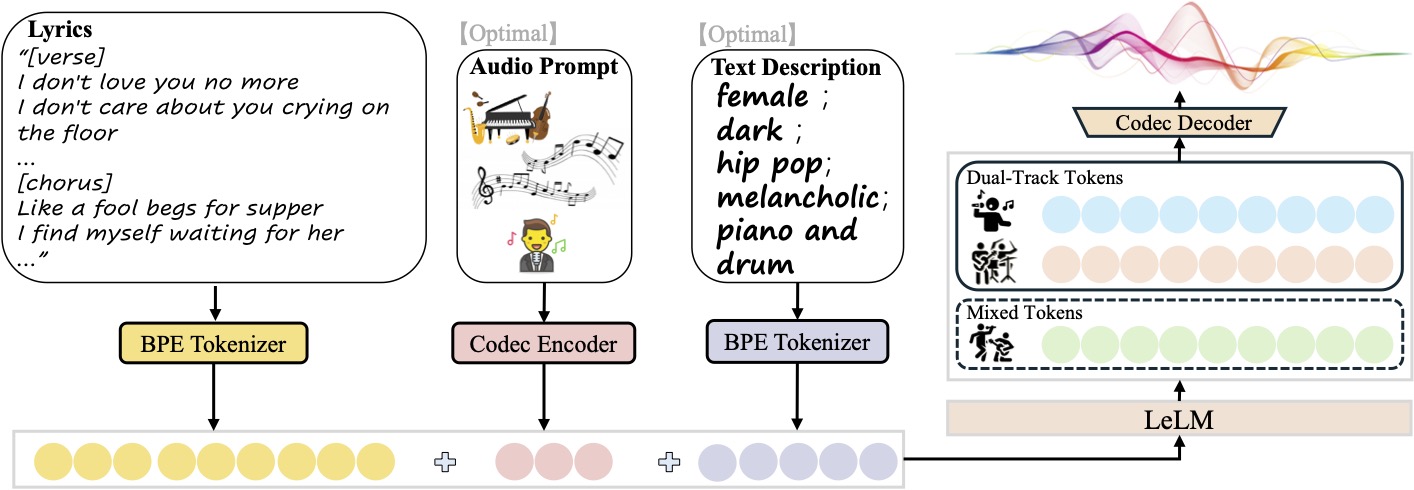

Diffuman4D是一个专注于从少量几个机位拍摄的视频中,生成可以在任意角度观看的、连贯流畅的4D人体动态影像的技术。传统的4D视频生成方法在处理稀疏视角的输入时,常常会出现画面不连贯、动作不协调的问题。为了解决这个难题,Diffuman4D采用了一种创新的时空扩散模型。该模型通过一个“滑动迭代去噪”的核心机制,在生成画面的过程中,同时优化空间维度(画面细节)和时间维度(动作流畅度)的一致性。此外,它还引入了4D人体姿态作为附加的条件,利用骨骼数据来提升最终生成视频的动作准确度和视觉真实感。实验结果表明,无论是在细节的清晰度,还是在复杂动作的捕捉上,Diffuman4D都展现了出色的性能,能够生成分辨率高达1024p的高清4D人体影像。

功能列表

- 高分辨率4D人体视频生成: 从稀疏视角的视频输入,生成分辨率高达1024p的4D人体动态影像。

- 自由视角观看: 生成的4D内容支持在任意新视角下进行观看,即使是拍摄时没有摄像机的位置也能生成连贯的画面。

- 提升时空一致性: 采用一种“滑动迭代去噪”技术,有效解决了传统方法中常见的画面闪烁、伪影和动作不连贯的问题。

- 精确的动作捕捉: 通过引入4D姿态作为条件,利用人体骨骼数据来显著提升生成视频中人物动作的准确性和自然度。

- 高效的推理过程: 创新的模型设计,在保证高质量输出的同时,也考虑到了计算效率,使得GPU显存的消耗在可控范围内。

- 良好的泛化能力: 在DNA-Rendering和ActorsHQ等多个数据集上进行了测试,证明了该方法对未曾见过的外观和动作也具有很好的处理能力。

使用帮助

Diffuman4D作为一个前沿的科研项目,其代码和数据目前正处在逐步开放的过程中。对于希望使用或研究该技术的用户,可以按照以下步骤来准备和操作。

第一步:环境准备

由于Diffuman4D是一个基于深度学习的模型,因此你需要一个配置有NVIDIA GPU和安装了相应驱动的Linux环境。具体的软件依赖包括:

- Python

- PyTorch

- Cuda

项目的开发者会提供详细的配置文件(如environment.yml),用户可以通过conda或pip来一键安装所有必需的Python库。

**第二...

(由于开发者尚未公布完整的安装和使用文档,以下根据项目技术原理提供一个预期的操作流程)

第二步:获取代码和数据

- 克隆代码仓库:首先,你需要从GitHub上克隆

Diffuman4D的官方代码仓库。打开终端,输入以下命令:git clone https://github.com/zju3dv/Diffuman4D.git cd Diffuman4D - 下载数据集:项目使用了经过特殊处理的DNA-Rendering数据集。开发者计划在GitHub仓库中发布这个处理过的数据集。请随时关注项目的更新,并根据届时提供的链接下载数据。下载完成后,你需要将数据集解压并放置在指定的

data目录下。

第三步:数据预处理(可选)

如果你有自己的稀疏视角视频数据,并希望用Diffuman4D进行处理,你需要进行一系列的预处理操作。项目将会提供数据预处理的相关脚本。这个过程大致包括:

- 相机参数校准: 准确计算每个视频流的内外参数。

- 色彩校正: 统一不同视角下视频的色彩风格,消除色差。

- 前景蒙版预测: 将视频中的人物主体从背景中精确地分离出来。

- 人体骨骼估计: 使用成熟的姿态估计算法,为视频的每一帧提取出人体骨骼的关键点数据。

这些步骤对于保证最终生成视频的质量至关重要,处理后的数据需要整理成模型要求的格式。

第四步:模型推理(生成4D视频)

当代码、数据和预训练模型都准备就绪后,你就可以开始进行推理,生成新的视角了。

- 下载预训练模型: 开发者会在项目中提供训练好的模型文件(通常以

.pth或.ckpt为后缀)。你需要下载并放到指定的checkpoints目录。 - 执行推理命令:打开终端,激活你的Python环境,然后执行推理脚本。虽然具体的命令尚未公布,但通常会是类似下面的形式:

python inference.py --config configs/dna_rendering_example.yaml --checkpoint_path checkpoints/diffuman4d.pth --output_path results/在这个命令中,你需要指定:

--config: 配置文件的路径,其中定义了数据路径、模型参数等信息。--checkpoint_path: 预训练模型的存放路径。--output_path: 指定生成视频的保存路径。

第五步:查看与交互

推理过程完成后,生成的4D影像会保存在你指定的输出目录中。项目主页提供了一个交互式的Demo,这预示着开发者可能会提供一个查看器工具,让用户可以方便地加载生成的4D模型,并从任意角度进行拖拽、缩放和播放,身临其境地体验自由视角观看的效果。

请密切关注官方GitHub仓库的更新,以获取最准确的安装流程、完整的代码、预训练模型和详细的使用说明。

应用场景

- 影视娱乐在电影和游戏的制作中,这项技术可以用来创建非常逼真的虚拟角色和数字替身。例如,只需要从几个角度拍摄演员的表演,就可以生成完整的、可以在虚拟场景中自由移动和交互的4D模型,大大降低了特效制作的成本和周期。

- 虚拟现实(VR)与增强现实(AR)用户可以体验到更加沉浸式的社交和娱乐内容。想象一下,在VR聊天中,你的朋友不再是一个卡通的虚拟形象,而是由这项技术生成的、动作和外貌都和你真人完全一致的4D数字人,这将带来前所未有的真实感。

- 体育赛事直播在足球或篮球比赛的直播中,观众将不再受限于固定的机位。他们可以自由选择任何想看的视角,比如从球员的视角、或者从空中俯瞰整个球场,获得“子弹时间”一样的酷炫观赛体验。

- 在线试衣与虚拟购物用户可以将自己的多角度视频上传,生成一个和自己身材、相貌完全一样的4D数字人。然后,就可以在线试穿各种虚拟服装,从不同角度查看上身效果,从而做出更明智的购买决策。

QA

- 这个项目和传统的3D建模有什么不同?传统的3D建模通常需要艺术家进行大量的手工劳动来创建模型和动画,过程漫长且成本高昂。Diffuman4D则是一种基于AI的方法,它能够自动地从真实拍摄的视频中学习并重建出带有时序变化的4D动态模型,在效率和真实感上都有巨大优势。

- 我需要多少个摄像机才能使用这项技术?这个项目的核心优势就是处理“稀疏视角”的输入,这意味着你不需要像传统方法那样动用几十甚至上百个摄像机。虽然具体的数量没有明确限制,但它旨在用尽可能少的视角(例如,几个)来达到高质量的重建效果。

- 这项技术对硬件的要求高吗?是的,作为一种基于扩散模型的深度学习技术,Diffuman4D在训练和推理阶段都需要强大的GPU支持。这对于希望获得实时生成效果的应用场景尤其重要。

- 最终生成的视频可以在哪些平台播放?生成的4D数据可以被导出为多种格式。最直接的是渲染成普通视频文件(如MP4),在任何标准播放器上观看。同时,它也可以被整合进游戏引擎(如Unity, Unreal Engine)或特定的Web查看器中,以实现交互式的自由视角观看体验。